La panne majeure survenue chez Cloudflare, le 18 novembre 2025, a marqué un tournant important dans la compréhension de la résilience du web mondial. Cet incident a paralysé un nombre significatif de plateformes et de services, provoquant des interruptions visibles pour des millions d’utilisateurs. Il met en lumière la dépendance massive à des fournisseurs d’infrastructure uniques et rappelle que même les géants technologiques peuvent échouer.

Cette défaillance démontre la nécessité, pour les entreprises, de revoir leurs architectures et de renforcer leurs plans de continuité. Elle invite également à analyser les causes profondes pour mieux anticiper les incidents futurs. Cet article revient sur les faits essentiels et propose des pistes solides pour réduire ce type de risque.

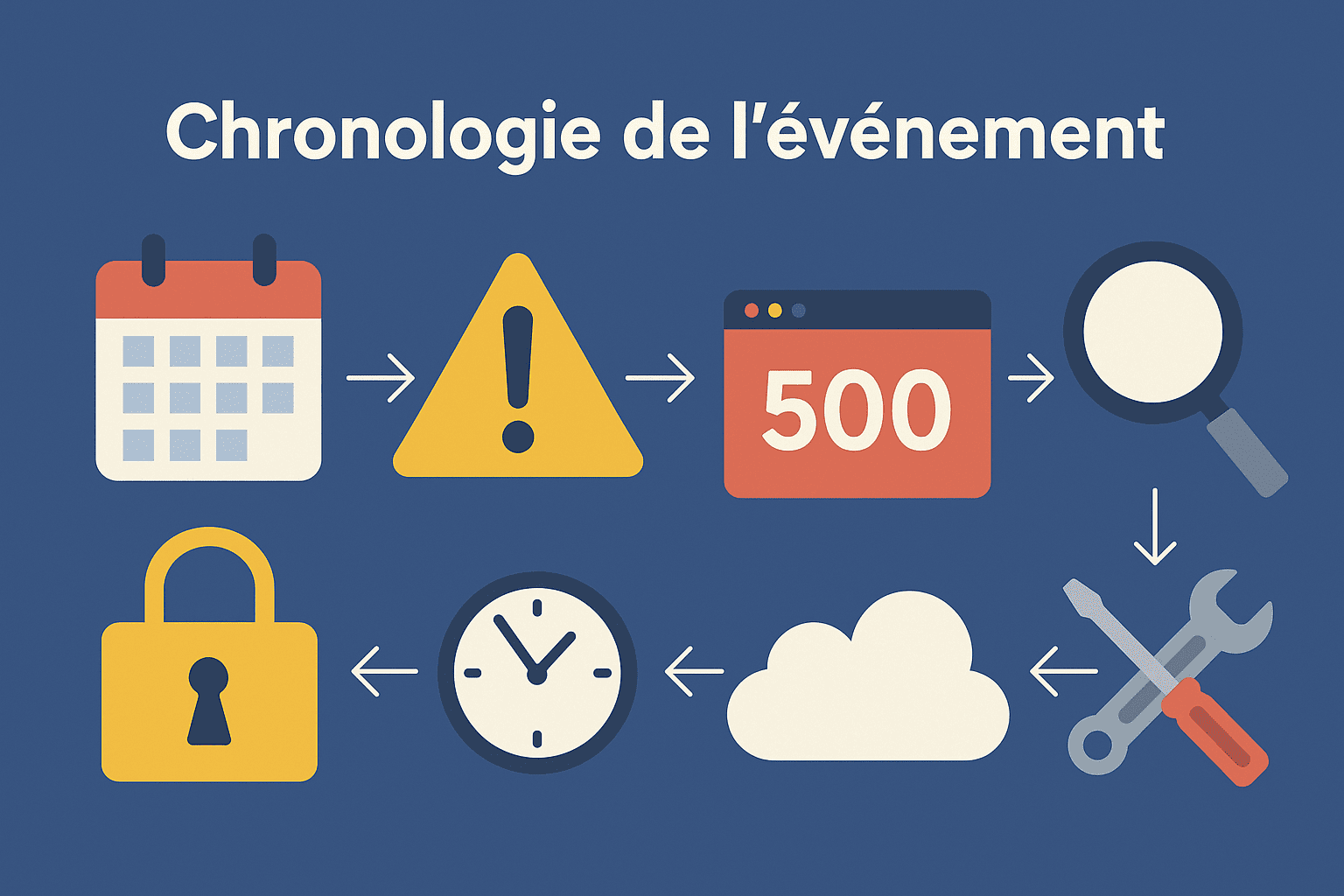

Chronologie de l’événement de la panne cloudflare

La panne débute vers 11 h 20 UTC, lorsque plusieurs anomalies sont détectées dans le réseau Cloudflare. Les utilisateurs commencent à rencontrer des erreurs massives de type HTTP 500, rendant de nombreux sites inaccessibles. L’incident se propage rapidement, affectant une large gamme de services et provoquant des ralentissements majeurs.

Les équipes techniques de Cloudflare entreprennent alors une analyse approfondie pour comprendre la cause du dysfonctionnement. Un correctif commence à être déployé vers 14 h 30, permettant une récupération progressive du réseau.

En fin d’après-midi, soit vers 17 h 00, la majorité des systèmes reviennent à un état stable, même si certains services resteront perturbés plus longtemps.

Les causes identifiées : un bug interne à l’origine

Le cœur de la panne réside dans un bug interne, lié à un fichier de configuration généré par un module de gestion des bots. Ce fichier, censé rester dans une taille limite, a été dupliqué et a soudainement dépassé la capacité prévue, provoquant un blocage puissant dans l’infrastructure. Ce dépassement a directement affecté le proxy central, incapable de traiter correctement les requêtes.

Le problème s’est propagé à plusieurs services internes, rendant l’analyse plus complexe. L’origine du fichier corrompu étant intermittente, certains tests semblaient fonctionner tandis que d’autres échouaient, ce qui a d’abord brouillé le diagnostic. Ce comportement instable a retardé le déploiement d’un correctif définitif.

Ce qu’il faut retenir :

- Bug interne et non attaque.

- Fichier de configuration corrompu.

- Dépassement des limites prévues.

- Effet cascade sur plusieurs services.

- Diagnostic rendu difficile par l’intermittence.

- Correctif appliqué après analyse approfondie.

3. Impacts techniques et économiques

La panne a provoqué des interruptions massives, rendant inaccessible un grand nombre de services web pendant plusieurs heures. Les interfaces de gestion Cloudflare ont elles-mêmes été affectées, rendant la supervision plus difficile pour les entreprises clientes. Plusieurs API essentielles ont cessé de répondre, entraînant des blocages pour des sites dépendant entièrement du réseau Cloudflare.

Sur le plan économique, les entreprises de trading et les plateformes e-commerce ont subi des pertes significatives, notamment en raison des abandons de panier et des interruptions de transactions. L’image technologique de Cloudflare a également été affectée, même si l’entreprise reste reconnue pour sa transparence et sa communication. Cet incident rappelle surtout la fragilité des chaînes de dépendances numériques.

Impacts majeurs observés :

- Erreurs 500 massives.

- API inaccessibles.

- Perte de transactions.

- Ralentissements étendus.

- Interfaces de gestion instables.

- Baisse temporaire de confiance.

Enseignements pour les professionnels du web

Cet incident prouve qu’une dépendance totale à un seul fournisseur n’est pas viable. Les professionnels doivent intégrer une logique de redondance, surtout via des solutions multi-CDN ou des DNS secondaires. Il est aussi indispensable de mettre en place une supervision continue pour détecter plus rapidement les anomalies.

La documentation des dépendances techniques joue un rôle essentiel pour comprendre les points de fragilité. Les entreprises doivent aussi tester régulièrement leurs plans de continuité pour s’assurer qu’ils fonctionnent. Enfin, cet épisode illustre l’importance d’une communication rapide et transparente en cas d’incident.

Bonnes pratiques recommandées :

- Utiliser plusieurs fournisseurs critiques.

- Mettre en place un monitoring avancé.

- Tester constamment la résilience.

- Documenter les dépendances internes.

- Prévoir un plan de crise.

- Communiquer clairement avec les utilisateurs.

Solutions alternatives et stratégies de mitigation

La première solution consiste à adopter un système multi-CDN, permettant de répartir la charge sur plusieurs réseaux. Cette approche garantit une meilleure continuité de service en cas de panne d’un fournisseur. L’utilisation d’un DNS secondaire est également essentielle pour assurer un basculement rapide.

Les entreprises doivent par ailleurs intégrer un plan de continuité détaillé, incluant les procédures d’analyse, les rôles de chaque membre et la communication externe. Une vérification régulière des dépendances techniques permet d’éviter les effets de surprise. Enfin, l’existence d’alternatives fiables offre de solides pistes pour diversifier son infrastructure.

Alternatives pertinentes à Cloudflare :

- Akamai

- Fastly

- StackPath

- Amazon CloudFront

- Azure CDN

- BunnyCDN

Conclusion

La panne Cloudflare du 18 novembre 2025 marque un rappel sévère : même les infrastructures les plus robustes peuvent rencontrer des défaillances critiques. Cet incident a démontré la nécessité, pour les entreprises, d’adopter des plans de continuité solides et une architecture diversifiée. Il met aussi en avant l’importance de comprendre ses dépendances techniques et de prévoir des sauvegardes fiables. Les solutions existent et permettent de réduire efficacement ces risques. En renforçant leurs infrastructures dès aujourd’hui, les organisations peuvent garantir une expérience stable et fiable à leurs utilisateurs, même face aux imprévus les plus sérieux.